di Elanor Colleoni, Università IULM

Gli algoritmi e l’Intelligenza Artificiale non sono solo tecnologie digitali che aiutano lo sviluppo dell’economia e della società (Flyverbom et al., 2019). Sono potenti forze che stanno rimodellando le nostre vite a tutti i livelli. L’Intelligenza Artificiale condiziona la nostra vita sociale non solo attraverso la raccomandazione di cosa comprare, a chi collegarsi, a quale lavoro candidarsi (Ma & Sun, 2020), ma viene utilizzata in ambiti sempre più disparati e controversi, quali la previsione di potenziali criminali e attacchi terroristici (Ganor, 2019), le decisioni di libertà provvisoria (Crawford, 2013), rilascio di mutui e finanziamenti (Ryman-Tubba et al., 2018), valutazione della salute (O’Neil, 2016), per citarne alcuni.

Il potere che l’Intelligenza Artificiale ha e può avere sulle nostre vite ha spinto numerosi studiosi ad analizzare l’impatto dell’Intelligenza Artificiale non solo da un punto di vista tecnico, ma anche sociale ed etico, andando a esplorare gli effetti che gli algoritmi hanno sulla società (Floridi, 2022). Floridi e il suo team di Oxford hanno mostrato come spesso gli algoritmi in effetti siano molto meno oggettivi di quanto si creda, creando o amplificando bias esistenti nella società. Per esempio, spesso l’Intelligenza Artificiale “imparando” su dati basati su comportamenti umani, ne incorpora e riproduce i bias, riproducendo discriminazioni contro donne o minoranze in generale nei suoi pattern. Secondo la AIAAIC, un’organizzazione no-profit, apartitica, creata per promuovere la trasparenza e l’onestà nel mondo dell’IA, il numero di crisi aziendali dovute ad effetti sociali o etici indesiderabili dell’utilizzo dell’Intelligenza Artificiale è aumentato vertiginosamente (come riportato in figura 1).

Sempre questi dati, mostrano come le crisi abbiano riguardato nel 70% circa dei casi gli Stati Uniti e nel restante 30% circa l’Unione Europea.

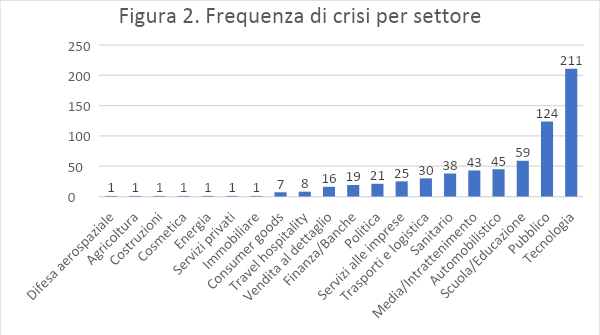

Nella figura 2 si riportano i settori più colpiti dalle crisi collegate all’utilizzo dell’IA. La figura mostra come il settore tecnologico sia il più colpito, essendo ovviamente dove si sperimenta di più. Risulta invece preoccupante il fatto che il Settore pubblico (e gli organi governativi) e l’educazione si trovino rispettivamente al secondo e terzo posto. In questi due settori sono molte le nuove tecnologie introdotte che spesso si sono rilevate avere degli effetti negativi sulla società.

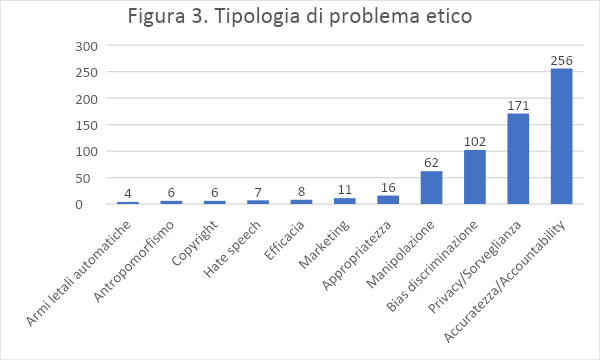

Nella figura 3 vengono mostrati i principali problemi etici generati dallo sviluppo, implementazione o utilizzo dell’Intelligenza Artificiale. Il problema principale riscontrato che più spesso ha portato a cause legali è quello dell’accuratezza e dell’affidabilità dell’IA. In questo ambito, numerosi sono i casi di incidenti avuti nei test-drive di automobili a guida automatica, o self-driving car, che vengono sperimentate da Tesla, Alphabet, Uber e altre. Il secondo problema etico riguarda il fatto che spesso queste tecnologie vengono utilizzate per aumentare il controllo su determinate parti della produzione, e spesso per fare questo, vengono controllati in modo indiscriminato anche i dipendenti delle aziende, violando la loro privacy. Infine, un altro elemento fondamentale che spesso porta a crisi aziendali e anche cause legali è l’effetto discriminante che può avere l’Intelligenza Artificiale a causa di come viene sviluppata o su quali segmenti della popolazione viene utilizzata.

Famoso è il caso riportato dalla scrittrice Kathy O’Neil di un algoritmo che aveva come obiettivo quello di identificare buoni e cattivi creditori per la banca, e che basandosi sul dato con cui era stato costruito, tendeva a segnalare come cattivi creditori chiunque provenisse da specifici distretti di alcune città americane, con l’effetto di discriminare intere fasce della popolazione afro-americana.

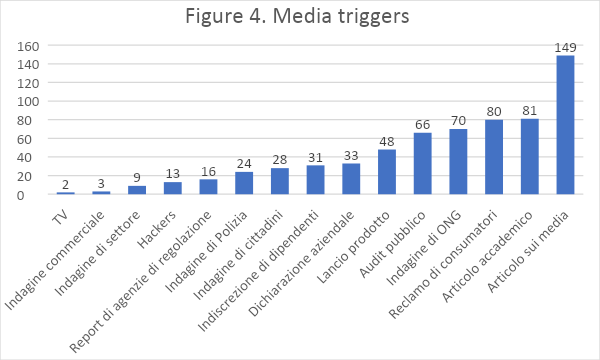

La figura 4 mostra attraverso quali canali la crisi generata dall’IA è stata resa pubblica, ovvero chi siano i media triggers, i responsabili dell’avvio della crisi. La figura mostra come i problemi causati dall’Intelligenza Artificiale vengono primariamente resi pubblici dai media attraverso articoli di approfondimento dei vari prodotti utilizzati o di casi di errori o inefficienze ad esse connessi. A seguire, gli studi accademici e report di approfondimento delle tecnologie utilizzate dall’Intelligenza Artificiale. Sono invece al terzo posto i reclami dei consumatori e al quarto posto le organizzazioni non governative. Da notare anche il numero di volte in cui i dipendenti hanno rilasciato informazioni rispetto al comportamento non etico dell’IA.

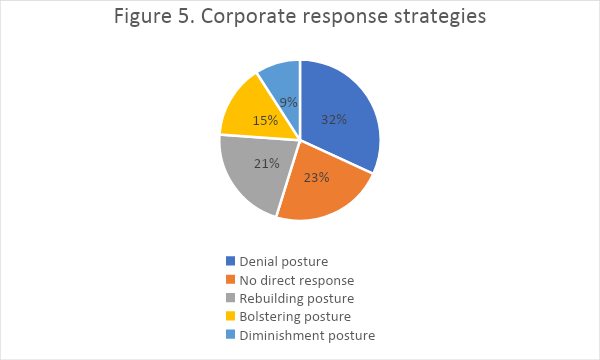

Nonostante la pervasività di questi effetti e l’aumento di crisi aziendali legate all’Intelligenza Artificiale, le aziende si trovano spesso impreparate rispetto a cosa rispondere quando accusati di comportamenti non etici. La figura 5 mostra come le aziende nella maggioranza dei casi (32%) decidano di negare le accuse (denial posture), mentre nel 23% dei casi decidano di non rispondere del tutto. Questo dato mostra, infatti, come le aziende si trovino nella maggior parte dei casi incapaci di dare risposte ponderate rispetto alle accuse. Interessante inoltre è come nel 15% dei casi le aziende utilizzino una strategia di bolstering, che consiste principalmente nel giustificare l’effetto indesiderato dell’IA come un piccolo problema rispetto al beneficio portato dall’utilizzo dell’IA. Solo il 21% delle aziende invece risponde in modo costruttivo (rebuilding strategy), assumendo la responsabilità dell’accaduto e avviando un vero e proprio cambiamento.

In conclusione, nonostante l’Intelligenza Artificiale rappresenti una grande opportunità da un punto di vista tecnico, è solo integrando la prospettiva del suo impatto sulla società tutta che si può riuscire a costruire dei prodotti che siano efficaci e al tempo stesso etici.